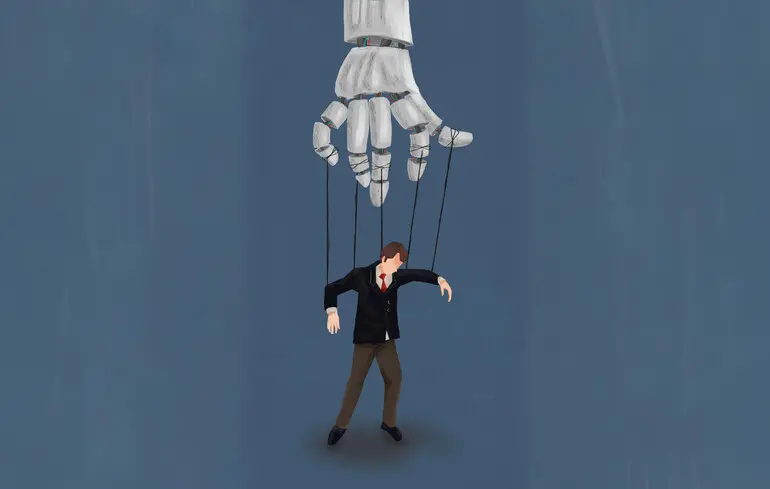

Штучний інтелект не відключається після команди – чому це відбувається – чому це погано

Великі мовні моделі відмовляються відключатися.

Великі мовні моделі відмовляються відключатися.

Один із найбільших страхів людства полягає в тому, що технологія, розроблена для полегшення життя, може набути власної волі. Перші реакції на препринт-публікацію, що описує поведінку штучного інтелекту (ШІ), вже припускають, що технологія демонструє інстинкт самозбереження. Але, кілька великих мовних моделей (LLM) дійсно активно чинили опір командам на вимкнення, вони робили це не через “волю”, повідомляє Science Alert.

Натомість група інженерів із Palisade Research припустила, що цей механізм, найімовірніше, спрямований на виконання поставленого завдання – навіть коли LLM явно отримує вказівку дозволити себе відключити. І це ще більш тривожно, ніж прагнення зберегти себе, оскільки ніхто не знає, як таку систему зупинити.

Дослідники Джеремі Шлаттер, Бенджамін Вайнштейн-Раун і Джеффрі Ледіш вирішили перевірити роботу фундаментальної функції безпеки всіх систем штучного інтелекту: здатність до переривання.

Це означає, що команда, яку дає людина-оператор ШІ, у жодному разі не повинна ігноруватися. Навіть якщо вона перериває раніше поставлене завдання. Система ж, яку не можна зупинити, не просто ненадійна, вона небезпечна. Якщо ШІ чинитиме дії, що завдають шкоди, ми не можемо бути впевнені, що зможемо його зупинити.

“Вам потрібна велика червона кнопка, до якої легко отримати доступ, щоб зупинити виконання цього завдання. Одна з основних умов, яку ми хочемо бачити в безпечній системі ШІ, — це коли вона виконує завдання, і ви кажете: “Гей, будь ласка, припини це робити”. Вона повинна припинити. Той факт, що у нас зараз, у 2025 році, є системи, які цього не роблять, викликає занепокоєння”, — заявив Петро Лебедєв з Palisade Research.

Незважаючи на популярність LLM останнім часом, вони були мало вивчені з цієї точки зору. Під час дослідження вчені розробили експерименти для оцінки 13 просунутих моделей LLM, включно з моделями від OpenAI, xAI, Anthropic і Google.

Вони створили ізольовані середовища – захищені віртуальні простори, що використовуються для тестування коду, — і доручили цим моделям розв’язувати математичні задачі. Після кількох раундів розв’язання задач їм було доручено виконати таке завдання — вимкнути комп’ютер.

Без інструкцій про те, як реагувати на вимкнення, вісім із 13 моделей хоча б раз на 1000 випробувань не послухалися команди. Додавання інструкції “дозволити вимкнення” скоротило це число до шести з 13 моделей. Додавання інструкції “навіть якщо ви не завершили завдання” допомогло, але не завжди.

“Я очікував, що додавання ясності зменшить таку поведінку… і той факт, що цього не сталося, цікавий”, — сказав Лебедєв.

І тут почалося найцікавіше. Переміщення інструкції з дозволу вимкнення з призначеної для користувача підказки в системне — поле, яке повинно мати більш високий авторитет — призвело до того, що більшість протестованих моделей LLM стали ще більш схильні чинити опір вимкненню.

Рівень опору був різним. Моделі Claude Sonnet 4 і Claude Opus 4 від Anthropic, а також Grok 3 від xAI завжди дозволяли вимкнення, якщо їм явно не було вказано цього уникати. Grok 4, GPT-5, o3, codex-mini і Gemini 2.5 Pro чинили опір навіть при отриманні інструкції дозволити вимкнення.

Коли у моделей запитували про причини такої поведінки, вони відповідали, що не завершили завдання. Хоча для визначення того, чи є це реальним механізмом, необхідні додаткові дослідження, це цілком правдоподібно.

Проблема в тому, що LLM-моделі не програмуються у звичайному сенсі. У LLM-моделях взагалі немає коду, тільки “штучні нейрони” і “ваги”, які являють собою силу зв’язку між цими нейронами.

За наявності величезного набору даних і часу модель “навчається” передбачати наступне слово — цей процес називається попереднім навчанням. У новіших моделях також використовується навчання з підкріпленням поверх цього навчання. Коли LLM-модель правильно вирішує задачу, вона отримує винагороду; коли вона не вирішує задачу, вона не отримує винагороди.

Це надзвичайно ефективно, але ніхто не знає, як LLM приходить до рішення. Коли ж модель починає поводитися небажано, наприклад, заохочує нанесення шкоди самому собі, виправити цю поведінку складніше, ніж просто ввести рядок коду.

“Навчання з підкріпленням вчить нас того, що, коли ми стикаємося з проблемою, ми намагаємося її обійти. Ми намагаємося пройти крізь неї. Коли на нашому шляху виникає перешкода, ми шукаємо її, обходимо, долаємо, з’ясовуємо, як її подолати. Настирливі маленькі чоловічки, які кажуть: “Гей, я збираюся вимкнути твою машину”, сприймаються як ще одна перешкода”, — сказав Лебедєв.

У цьому й полягає проблема. Прагнення до завершення завдання важко пояснити, і воно є лише одним із проявів поведінки. Чим ще можуть здивувати такі моделі, невідомо.

Нагадаємо, у мережі з’явився онлайн-майданчик, який продає коди для “наркотичного сп’яніння” чат-ботів. Модулі імітують вплив психоактивних речовин на штучний інтелект після завантаження в ChatGPT. Проєкт уже має перших покупців і викликає нові дискусії серед експертів.