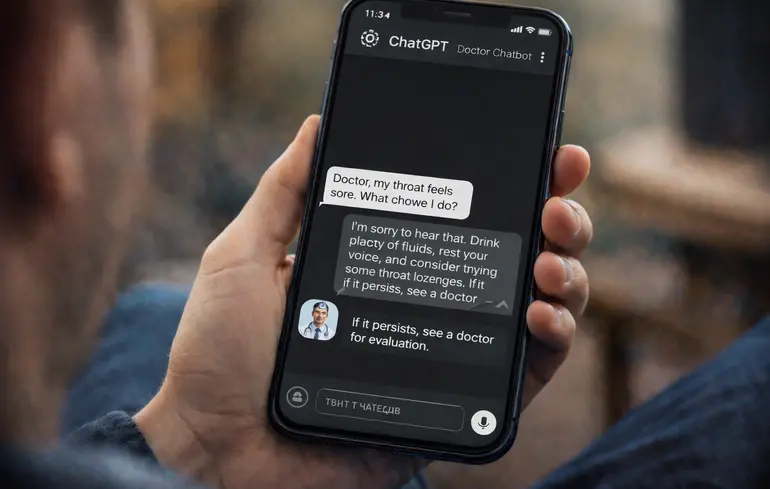

Дослідження Оксфордського університету виявило, що штучний інтелект може бути небезпечним для надання медичних рекомендацій, оскільки вводить користувачів в оману.

Чат-боти з високими тестовими балами погано працюють у реальних сценаріях лікування людей.

Чат-боти з високими тестовими балами погано працюють у реальних сценаріях лікування людей.

Застосування чат-ботів на основі штучного інтелекту для отримання медичних рекомендацій може становити ризик для пацієнтів. Чат-боти часто надають неточну або суперечливу інформацію. До такого висновку дійшли науковці з Оксфордського інтернет-інституту та кафедри первинної медичної допомоги Наффілда Оксфордського університету, повідомляє BBC.

Дослідження, опубліковане в журналі Nature Medicine, продемонструвало, що штучний інтелект має тенденцію надавати неточну та суперечливу інформацію, що створює ризики під час ухвалення медичних рішень. Незважаючи на високі результати на стандартизованих тестах, ШІ не забезпечує коректної поведінки в реальних умовах.

“Незважаючи на весь ажіотаж, штучний інтелект просто не готовий виконувати роль лікаря”, — зазначила співавторка дослідження доктор Ребекка Пейн. Вона підкреслила, що проблема полягає не лише в якості відповідей, а й у взаємодії між людиною та моделлю.

У рамках рандомізованого дослідження вчені залучили 1298 повнолітніх учасників із Великої Британії. Їм було запропоновано десять медичних сценаріїв і попросили визначити можливі захворювання та рекомендовані дії.

Частина учасників використовувала мовні моделі GPT-4o, Llama 3 або Command R+, тоді як контрольна група застосовувала звичні методи, зокрема інтернет-пошук або власні знання. Результати показали, що користувачі з ШІ визначали правильні захворювання менш ніж у 34,5% випадків.

Водночас саме програмне забезпечення демонструвало значно вищі показники точності під час окремого тестування без участі людей. Це свідчить про те, що ключовою проблемою є взаємодія користувачів із моделями, а не лише їхні знання.

“Пацієнти повинні усвідомлювати, що запитувати модель з великою кількістю мов про свої симптоми може бути небезпечно”, — наголосила Пейн. Вона додала, що це може призвести до помилкових діагнозів або ігнорування ситуацій, коли потрібна термінова допомога.

Провідний автор дослідження Ендрю Бін зазначив, що навіть найкращі мовні моделі стикаються з труднощами під час реальної взаємодії з людьми. Він висловив сподівання, що “ця робота сприятиме розробці більш безпечних та корисних систем штучного інтелекту”.

Дослідники рекомендують проводити систематичне тестування за участю реальних користувачів перед впровадженням ШІ у сфері охорони здоров’я. На їхню думку, стандартні бенчмарки та симуляції не здатні виявити ключові ризики для пацієнтів.

Це дослідження зʼявилося після випуску спеціальних сервісів для роботи з питаннями щодо здоровʼя компаніями Anthropic та OpenAI. Claude for Healthcare орієнтований на клінічну практику, адміністрування та взаємодію з пацієнтами. За даними Anthropic, він має допомогти лікарям скоротити час на рутинні процеси, а пацієнтам — краще розуміти медичну інформацію.

ChatGPT Health від OpenAI допомагає тлумачити результати аналізів, готуватися до візитів до лікаря, аналізувати дані з носимих пристроїв і порівнювати варіанти страхування. Водночас сервіс не призначений для діагностики чи лікування і має лише підтримувати медичні рішення.