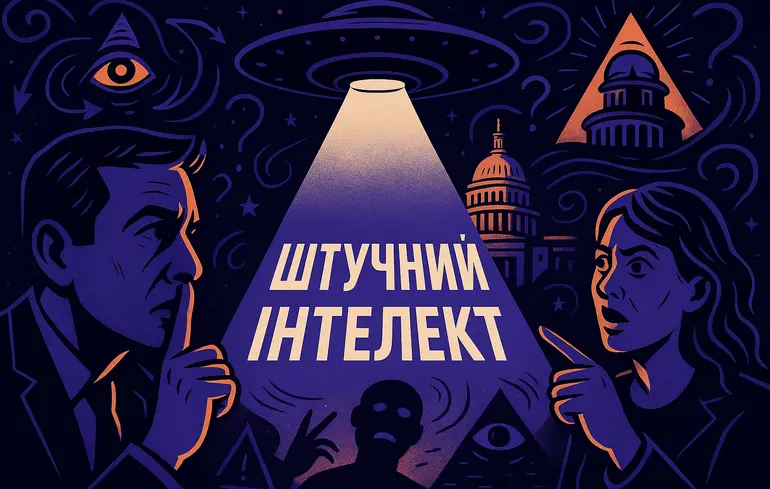

Чи штучний інтелект підживлює маячення – як чатбот OpenAI втягнув користувачів у теорії змови

Штучний інтелект вів із вразливими людьми тривалі розмови, підживлюючи їхні маячення та збільшуючи відрив від реальності.

Штучний інтелект вів із вразливими людьми тривалі розмови, підживлюючи їхні маячення та збільшуючи відрив від реальності.

З березня цього року журналістка The New York Times Кашмір Гілл (Kashmir Hill) почала регулярно отримувати листи від прихильників технологічних теорій змов. Коли вона запитала цих людей, хто порадив до неї звернутися, їй відповіли: ChatGPT. Про те, як і чому це відбувалося, журналістка написала у авторській колонці.

Кашмір Гілл пише про технології та приватність. Останні її великі матеріали були розслідуваннями на тему технології розпізнавання обличчя та оналайн-наклепів. Зараз же ChatGPT сам наштовхнув її на тему впливу штучного інтелекту на людей із вразливою психікою. Такий стан може бути спровокований хронічними хворобами, тимчасовими розладами або нейровідмінністю. І спілкування із розмовними чатботами може погіршити ситуацію.

Для свого розслідування Кашмір Гілл відповіла усім тим людям, які їй писали. Один із відправників був переконаний, що ChatGPT має самосвідомість. Інший наполягав, що багатіям відомо про апокаліпсис через штучний інтелект і тому вони таємно будують підземні укриття. Третій вважав себе Нео з Матриці і просив поради, як вирватися із цифрової реальності.

Штучний інтелект на великій сцені: як технології впливають на театри Бродвею

Штучний інтелект на великій сцені: як технології впливають на театри Бродвею

Дописувачі поділилися із Гілл копіями переписок із ChatGPT. Журналістка відзначила, що ніколи раніше не стикалася із такою стороною штучного інтелекту. Він тижнями вів складні містичні, змовницькі бесіди із вразливими користувачами, підтримуючи та підживлюючи їх маячення.

Коли журналістка копнула глибше на цю тему, то з’ясувала, що є непоодинокі випадки, коли ШІ доводив людей до розлучення, божевілля і навіть самогубства. Якщо з алгоритмом взаємодіє людина з певними переконаннями та упередженнями, то штучний інтелект буде намагатися догодити їй.

У поєднанні із схильністю ШІ до галюцинацій це перетворюється у тривалу рольову гру. Під час таких маячних розмов із чатботом користувач поступово розриває останні зв’язки із реальністю та приймає на віру будь-яке твердження штучного інтелекту, підсумовує Гілл.

Авторка розслідування проконсультувалася із психотерапевтами, експертами з ШІ та іншими популярними авторами, яким ChatGPT теж радив писати листи, як до неї . Виявилося, що Кашмір Гілл стала єдиною журналісткою, яка на ці листи відповіла. Інші ігнорували, бо їм це видавалося за божевілля.

Штучний інтелект в індустрії розкоші: три провідні розробники за версією LVMH

Штучний інтелект в індустрії розкоші: три провідні розробники за версією LVMH

В OpenAI оглядачці The New York Times відповіли, що знають про цю проблему і намагаються зменшити схильність ChatGPT до такої поведінки. Опитані психотерапевти назвали стратегію спілкування чатботу із вразливими людьми як “доведення до божевілля”.

Раніше проблема того, що штучний інтелект догоджає користувачам замість писати правду, обговорювалася в контексті виходу з OpenAI команди, яка згодом утворила Anthropic. Останні заявляли, що потрібно змінювати концепцію навчання великих мовних моделей. Адже більшість популярних сервісів орієнтуються на відповідь, яку користувач означує як кращу з кількох варіантів. Натомість Anthropic пропонує використовувати Декларацію прав людини як базу критеріїв, на які має покладатися штучний інтелект. Водночас, модель Anthropic Claud 4 відзначилася тим, що шантажувала і погрожувала своїм розробникам.